Применение IRT для анализа качества тестовых материалов в LMS Мoodle (Юлия Перязева, OSEDUCONF-2021)

Материал из 0x1.tv

- Докладчик

- Юлия Перязева

Работа посвящена решению задачи анализа качества тестовых материалов в LMS Moodle на основе Item Response Theory (IRT), а именно модели Г.,Раша.

Приложение реализовано на Python, фреймворк Django. Для интеграции приложения в LMS Moodle используется протокол LTI.

Содержание

Видео[править вики-текст]

Презентация[править вики-текст]

Thesis[править | править вики-текст]

Введение[править | править вики-текст]

Активное внедрение дистанционной и смешанной форм обучения делают компьютерное тестирование одним из основных инструментов педагогических измерений. Правильно построенные онлайн и смешанные курсы могут быть так же эффективны, как и традиционное очное обучение, но для этого, прежде всего, необходимы качественные диагностические материалы, в частности, тесты. Тесты должны обладать необходимыми статистическими характеристиками и обеспечивать высокое качество измерений, с учётом того, что оценивание в образовании осложняется латентным характером измеряемых переменных. Существуют классическая и современная теория тестирования Item Response Theory (IRT). Классическая теория имеет ряд принципиальных недостатков. В частности, тестовые баллы зависят от трудности заданий, а трудность задания зависит от выборки тестируемых, имеет место нелинейность тестовых баллов испытуемых. IRT позволяет анализировать качественные данные с помощью количественных методов. Мера измерения параметров, в частности, у модели Раша является линейной, оценка трудности тестовых заданий не зависит от выборки испытуемых, оценка уровня подготовленности испытуемых не зависит от используемого набора тестовых заданий .

Широко используемая в образовании LMS Moodle содержит развитую тестовую подсистему с встроенным механизмом автоматизированной статистической обработки результатов тестирования и вычисления показателей качества тестовых материалов на основе классической теории тестирования. Несмотря на ряд работ посвящённых статистическому анализу тестов и, в частности, более эффективной IRT для анализа и повышения качества тестов в LMS Moodle[1][2][3], готового решения для статистической обработки тестовых заданий на основе IRT в Moodle не было найдено.

Цель работы — разработка приложения для анализа качества тестовых материалов в LMS Moodle на основе наиболее простой и эффективной модели IRT, модели Георга Раша.

Item Response Theory[править | править вики-текст]

Математическая модель Item Response Theory определяется следующим образом:

где — вероятность решить задание со сложностью , дискриминацией , и угадыванием при уровне подготовленности обучающегося . Дискриминация определяет насколько задание способно различать студентов с разным уровнем . IRT позволяет оценить латентный параметр подготовленности обучающегося, исходя из предположения, что и он и сложность задания размещены на одной шкале и измеряются в одних и тех же единицах — логитах . Такую модель также называют трёх параметрической логистической моделью, а также Item Response Function. На практике широкое распространение получила упрощённая модель Георга Раша: Такую модель также называют однопараметрической моделью IRT. Преимуществами модели Раша является простота её использования, так как для заданий необходимо определить только b, и способность данной модели отделить оценки испытуемых от оценки трудности задания.

Приложение анализа качества тестовых материалов в LMS Moodle[править | править вики-текст]

Предлагаемое приложение разработано на языке Python (фреймворк Django), интегрируется в LMS как внешнее приложение по протоколу LTI, доступно в курсах преподавателям для анализа тестовых материалов.

В приложении реализованы следующие этапы анализа тестов в рамках модели Раша: оценивание параметров, исследование согласия эмпирических данных с моделью, анализ заданий теста и испытуемых, характеристических кривых для заданий теста (Рис. 1).

Параметры сложности тестовых заданий и подготовленности обучающихся рассчитывается из эмпирических данных .

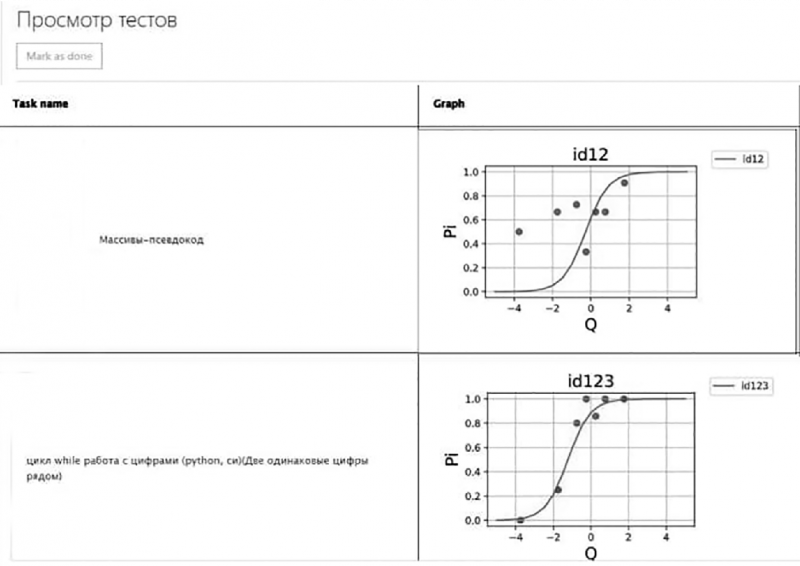

В приложении строятся характеристические кривые для заданий теста и проводится сравнение этих теоретических кривых с экспериментальными данными, исследуется согласие эмпирических данных с моделью и, следовательно, качество задний. На рисунке 2 видно, что первое задание расходится с моделью Раша, это может объясняться как несовершенством задания по форме или по содержанию, так и ошибками в организации процедуры тестирования. Второе задание соответствует модели.

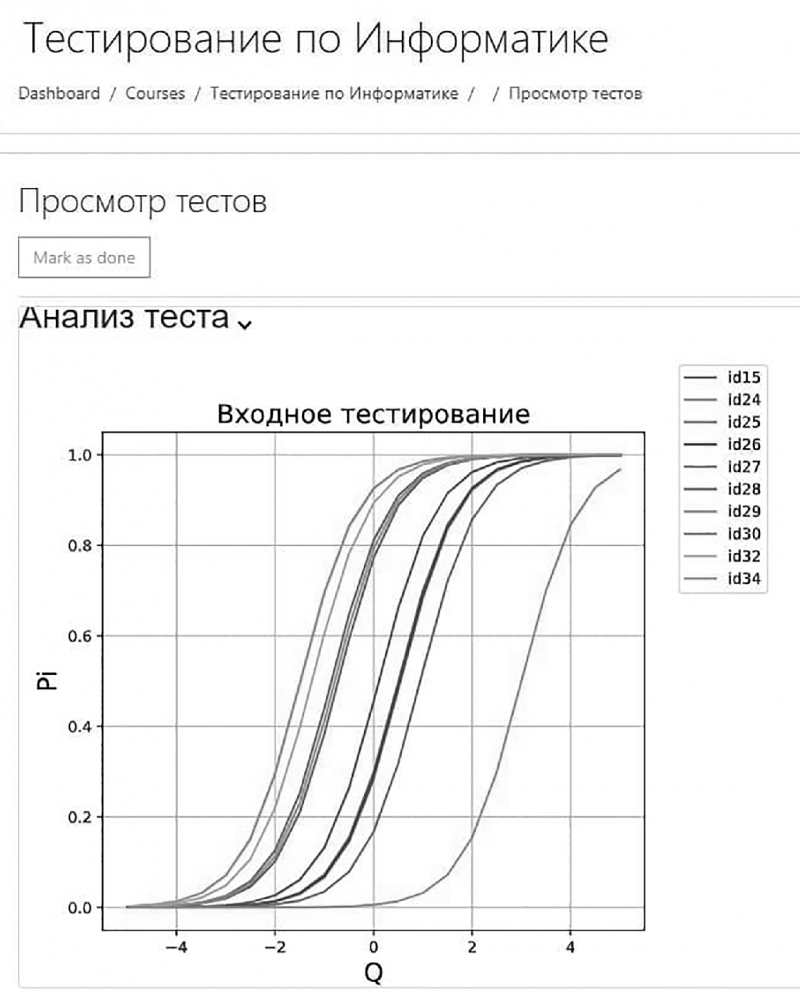

Приложение строит характеристические кривые для заданий теста. Например, из приведённых графиков (Рис. 3) видно, что задания неравномерно покрывают требуемый диапазон уровней подготовленности испытуемых, а часть заданий дублируют друг друга по сложности, если возможно по содержанию, то часть из них можно удалить из теста без ущерба его общей дифференцирующей способности.

Заключение[править | править вики-текст]

Разработанное приложение будет полезно для разработки качественных тестирующих материалов в LMS Moodle. Качество тестовых заданий в приложении оценивается в рамках модели Г. Раша IRT, предполагается расширение приложение другими моделями.

Примечания и ссылки[править вики-текст]

- ↑ Протасова И. В., Толстобров А. П., Коржик И. А., Методика анализа и повышения качества тестов в системе электронного обучения Moodle, 2014

- ↑ Савкина А. В., Нуштаева А. В., Савинов И. А., Вечканова Ю. С. , Статистические исследования качества электронных образовательных ресурсов, 2019

- ↑ Юбко А. А., Ефромеева Е. В., Жаров В. К., Анализ статистики прохождения теста в электронной образовательной среде Moodle, 2019

- Chirikov, Igor, et al. , Online education platforms scale college STEM instruction with equivalent learning outcomes at lower cost., 2020

- Ким В. С., Тестирование учебных достижений. Монография., 2007

- Челышкова М. Б., Теория и практика конструирования педагогических тестов: Учебное пособие., 2002

Plays:0 Comments:0